Clustern mit Corosync

Die HA-Fähigkeit eines Proxmox-VE-2-Clusters beruht dagegen auf dem Corosync-Kommunikations-Stack

[10]

sowie der Red Hat Cluster-Suite

[11]

. Das dazu eigens entwickelte Datenbank- und FUSE-basierte Proxmox Cluster Filesystem (

»pmxcfs«

)

[12]

ermöglicht es, die Konfiguration der einzelnen Cluster-Knoten über den Corosync-Kommunikations-Stack zu nutzen und auf DRBB zu verzichten.

Da Proxmox auf diese Weise sämtliche Konfigurationsdateien, die clusterweit identisch sein müssen, im Pmxcfs vorhält, können auch alle PVE-Nodes darauf zugreifen. Ferner unterstützt ein Proxmox-VE-2-Cluster verschiedene Authentifizierungsverfahren, neben der lokalen Authentifizierung auch Active Directory und LDAP. Darüber hinaus beherrscht er die Rollen-basierte Verwaltung sämtlicher Cluster-Objekte (Nodes, Storages, virtuelle Maschinen) und ist außerdem in der Lage, Multi-Master-Cluster zu erstellen (wie beschrieben unterstützten gewöhnliche Proxmox-VE-Cluster nur Single-Master-Setups).

Cluster Manager Toolkit

Die erforderliche Corosync-Konfiguration wird mithilfe der Befehle des Proxmox VE Cluster Manager Toolkit [13] automatisch auf jedem Knoten erzeugt und ist unter anderem dafür verantwortlich, dass die Nodes im Cluster miteinander kommunizieren, was wiederum voraussetzt, dass sich sämtliche Nodes im gleichen Subnetz befinden. Das automatische Abstimmen der Nodes erfolgt dann via IP Multicasts, was allerdings bei manchen Switches eine manuelle Aktivierung erfordert. Ferner müssen Datum und Zeit zwischen den Notes synchronisiert sein. Außerdem nutzt die Konfiguration einen SSH-Tunnel auf Port 22. Der Datenverkehr der VNC-Konsole ist dagegen seit PVE 2.0 über SSL gesichert und nutzt die Ports 5900 und 5999.

Für das weitere Vorgehen muss der Admin zunächst auf jedem für den PVE-2-HA-Cluster vorgesehenen Node PVE über den Bare-Metal-Intaller installieren.

Dabei muss er darauf achten, gleich zu Angfang den finalen Hostnamen und eine statische IP-Konfiguration festzulegen, weil das Ändern der IP-Adresse oder des Hostnamens nach der Cluster-Erzeugung nicht mehr möglich ist. Auch wenn der fertige Cluster inzwischen über das Webinterface verwaltet und genutzt werden kann, muss der Admin zum Aufsetzen des PVE-HA-Clusters auf das Proxmox VE Cluster Manager Toolkit zurückgreifen, das auf jedem Node die Corosync-Konfiguration erzeugt. Seine vollständige Syntax findet sich hier [15] .

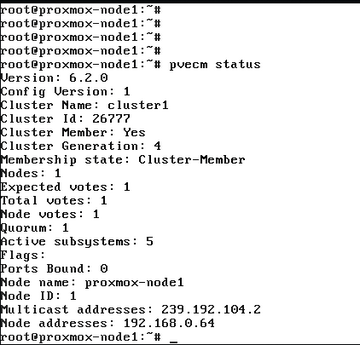

Um einen Cluster anzulegen, meldet sich der Admin zunächst via SSH auf dem ersten VE-Node an und erzeugt mit

»pvecm create Cluster-Name«

einen ersten Cluster, dessen Status er anschließend mit

»pvecm status«

prüfen (

Abbildung 1

) kann.

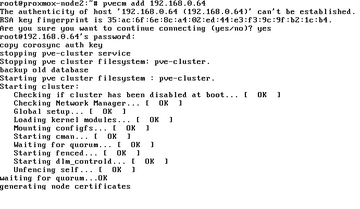

Zum Hinzufügen eines Nodes zu einem bereits existierenden Cluster loggt sich der Admin via SSH auf einem anderen PVE-Node ein und fügt dort diesen Node mit dem Befehl

»pvecm add IP-Cluster«

zum angegebenen Cluster hinzu (

Abbildung 2

).

Abbildung 2: Zum Hinzufügen eines Nodes zum bestehenden Cluster loggt sich der Admin via SSH auf einem anderen PVE-Node ein und fügt dort diesen Node zum angegebenen Cluster hinzu.

Abbildung 2: Zum Hinzufügen eines Nodes zum bestehenden Cluster loggt sich der Admin via SSH auf einem anderen PVE-Node ein und fügt dort diesen Node zum angegebenen Cluster hinzu.

Ist das geschehen, lässt sich auch hier mit

»pvecm status«

der neue Status des Clusters verifizieren. Mit

»pvecm nodes«

dagegen kann der Admin sämtliche im Cluster enthaltenen Nodes anzeigen. Zum Entfernen eines Cluster-Nodes muss der Admin ebenfalls die Kommandozeile bemühen. Lediglich das Löschen oder Migrieren von virtuellen Maschinen kann und muss über das Webinterface erfolgen. Soll ein Cluster-Node entfernt werden, muss der Admin etwaige existente und noch benötigte VMs vorher durch Migrieren oder Sichern (Snapshot) erhalten. Das Löschen des Nodes funktioniert dann mit

»pvecm delnode <node-nr>«

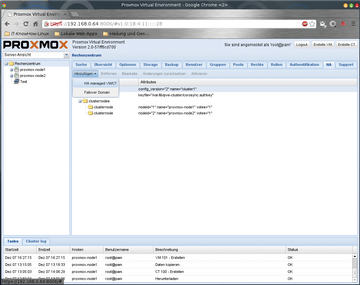

. Wurde die Corosync-Konfiguration auf diese Weise erstellt, lässt sich im Web-GUI im Reiter "HA" (

Abbildung 3

) wahlweise eine Failover-Domain hinzufügen oder eine HA-managed-VM beziehungsweise ein HA-managed-CT (Ressource-Container) hinzufügen.

Das GUI zeigt die dazu notwendigen Änderungen im Bereich "Ausstehende Änderungen" an.

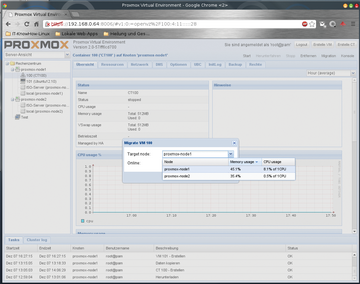

Mit einen Klick auf "Aktivieren" lässt sich die Konfiguration abschließen. Dank Corosync wird der Zustand jedes Nodes zwischen allen Knoten repliziert, die in die Corosync/HA-Konfiguration eingebunden sind. Außerdem lassen sich problemlos VMs oder CTs zwischen den beteiligten physischen Nodes migrieren ( Abbildung 4 ). Die Konfiguration sorgt außerdem für ein Cluster-weites Logging.