Was die Cloud leisten kann

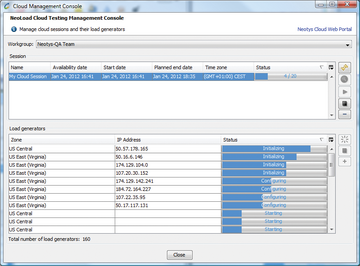

Die Cloud, zumal wenn verschiedene Clouds zusammengeschaltet werden, ist fast grenzenlos skalierbar, um selbst robuste Anwendungen zu stressen ( Abbildung 3 ). Aber die Stärke der Cloud kann auch ein Nachteil sein, wenn Anwendungen aus Nutzersicht zu testen sind. So haben die realen Besucher einer Website häufig weniger Bandbreite zur Verfügung als ein Lastgenerator beziehungsweise die künstlich erzeugten Nutzer. Es kann in Wirklichkeit länger dauern, um die relevanten Daten für eine Website oder Anwendung herunterzuladen als der Lasttest ermittelt.

Das hat Konsequenzen: Die Testingenieure könnten die Performanz für akzeptabel halten, obwohl sie sich für den realen Anwender bereits im roten Bereich bewegt, sodass er die Website noch vor der Konversionshandlung verlässt oder als schlechten Service erlebt. Dauern die Antwortzeiten länger, erhöht sich außerdem auch die Zahl gleichzeitig aufgebauter Verbindungen. Unter Testlast ist der Server dann einer geringeren Belastung ausgesetzt als in Wirklichkeit, selbst wenn die Menge der Browseranfragen gleich gewählt ist.

Eine Lasttestlösung sollte daher eine Bandbreitensimulation unterstützen, die den Datendurchsatz kontrolliert. Das ist noch wichtiger, wenn es um Apps und mobile User geht, die sich selbst beim HSDPA (3,5 G)-Standard mit einer Datentransferrate von häufig weniger als 100 KByte/s zufriedengeben müssen. Ebenso sollte eine Lasttestlösung parallele HTTP-Anfragen simulieren können, da die gleichzeitigen Downloads die Antwortzeiten verlängern und die Anzahl der Verbindungen erhöhen.

Extern testen, Interna schützen

Lasttests innerhalb der Firewall sind sicher, aber weniger authentisch, als von außen generierte Nutzeranfragen. Wer von außerhalb testet, sollte sich allerdings bewusst sein, dass die Zahl und Konfiguration der virtuellen User sowie ihr realitätsnah simuliertes Verhalten viel über das Geschäftsmodell, den Geschäftserfolg, die technische Umsetzung und Systemprobleme verrät. Natürlich werden keine realen Kundendaten, aber doch aus der Realität abgeleitete Größen zwischen der eigenen Infrastruktur und einer öffentlichen Cloud ausgetauscht. Virtuelle Nutzerkonten, Zugriffsszenarien, detaillierte Fehlermeldungen und andere vertrauliche Daten müssen daher geschützt werden.

Das geschieht am besten durch eine starke Verschlüsselung der Kommunikation zwischen dem Controller (der festlegt, was die Lastgeneratoren tun sollen) und den Last erzeugenden Servern – und zwar in beide Richtungen: Eine SSL-Verschlüsselung sorgt dafür, dass sowohl die Steuerungsbefehle an die Lastgeneratoren als auch die zurückgelieferten Performanz-Messungen nicht abgefangen, ausgelesen und eventuell an Wettbewerber weitergegeben werden können. Wichtig ist darüber hinaus, transparente und detaillierte Informationen über die technischen, organisatorischen und rechtlichen Rahmenbedingungen der Cloud-Services vom Provider zu erhalten, eindeutige vertragliche Regelungen zu treffen und die Umsetzung abgestimmter Sicherheitskonzepte verbindlich zu regeln.